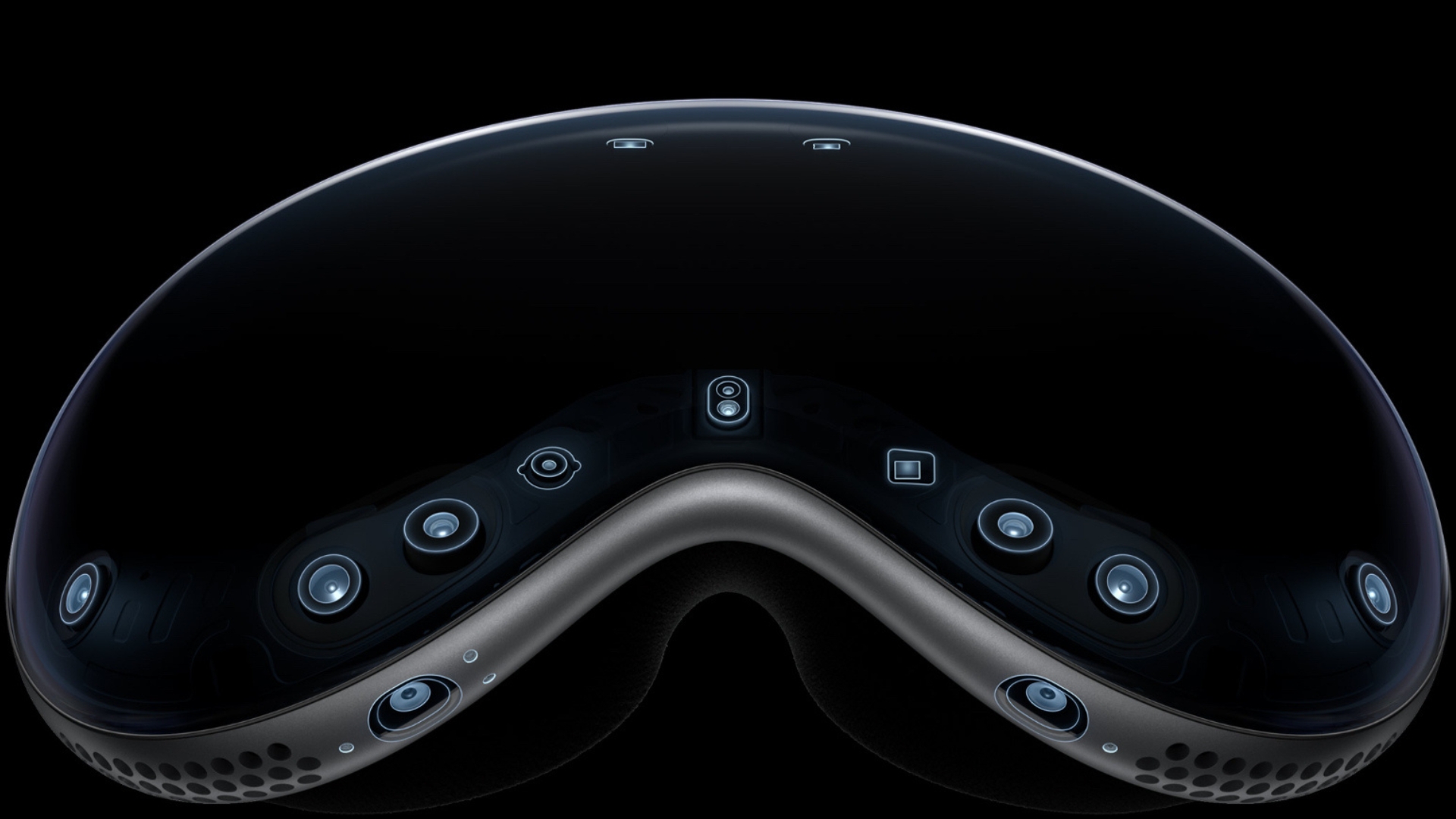

O mundo está atualmente impressionado com o novo e revolucionário fone de ouvido Vision Pro AR/VR da Apple, que consegue parecer simultaneamente um pouco de tecnologia de 10 anos no futuro, e um par de óculos de esqui comuns do ‘ anos 90. Mas com o Vision Pro, não é o exterior que conta – é o interior onde toda a ação acontece, e são os sensores que ele contém que tornam possível inaugurar a era da computação espacial e ser o divisor de águas que A Apple espera que sim.

Aqui, vamos nos aprofundar em como o Vision Pro faz sua mágica usando sensores para rastrear você e o que todos eles são capazes de fazer.

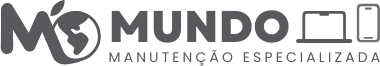

Câmeras de rastreamento

Primeiro, vamos dar uma olhada nas câmeras na parte externa do dispositivo. Estes são os duas câmeras principais de alta resolução e seis câmeras de rastreamento voltadas para o mundo que detectam o seu ambiente em 3D estereoscópico. Se você conhece o Vision Pro, sabe que ele pode tirar fotos e gravar vídeos do que você está vendo, e é para isso que as câmeras principais são usadas. A interface principal do Home View do Vision Pro (que você usa para acessar todos os seus aplicativos e experiências) é navegada por uma combinação de movimentos oculares e gestos com as mãos. Basta olhar para um ícone e tocar os dedos para selecionar. É por isso que existem tantas câmeras de rastreamento voltadas para o mundo exterior, para que o Vision Pro possa detectar até mesmo os menores movimentos dos dedos. Para ampliar uma foto que você está vendo, por exemplo, basta olhar para o canto da foto e apertar e arrastar com os dedos – esse movimento com a mão e o braço é bem pequeno, mas o Vision Pro irá detectá-lo graças a as seis câmeras de rastreamento.

Agora vamos dar uma olhada no interior do dispositivo. O rastreamento ocular (não o EyeSight – isso é algo diferente) é obviamente muito importante para o Vision Pro. Ele precisa ser capaz de discernir o movimento dos olhos dentro do fone de ouvido, e isso é feito quatro câmeras infravermelhas internas de rastreamento que rastreiam cada movimento que seus olhos fazem. Portanto, graças a essas quatro câmeras, se você simplesmente optar por olhar diretamente para um ícone na interface do Home View, ele estará selecionado. Mas o Vision Pro também contém outra câmera interna, uma Câmera TrueDepth, para que possa autenticar o usuário. As câmeras TrueDepth foram introduzidas pela primeira vez no iPhone para FaceID e contêm alguns dos hardware e software mais avançados que a Apple já criou para capturar dados faciais precisos. Milhares de pontos invisíveis são projetados em seu rosto para criar um mapa de profundidade, e uma imagem infravermelha também é capturada. Agora, se o Vision Pro está fazendo isso em todo o seu rosto ou apenas nos olhos, não temos certeza, pois ele usa autenticação biométrica baseada na íris, mas certamente está usando a tecnologia TrueDepth para ajudá-lo a fazer isso.

Leitor LiDAR

LiDAR é outra tecnologia que a Apple já utilizou nos melhores iPhones e iPads do passado. LiDAR significa Light Detection and Ranging e emite um laser para medir com precisão a distância que os objetos cercados estão. A Apple afirma que o scanner LiDAR no iPhone permite tirar fotos melhores no escuro, ajudando a câmera a focar automaticamente seis vezes mais rápido, para que você não perca uma ótima foto.

Você não precisa fazer nada para que isso aconteça – basta apontar sua câmera no escuro e tirar uma foto. A Apple também tem seu aplicativo Measure gratuito que pode usar o scanner LiDAR para medir distâncias para você. Então, o que isso está fazendo no Vision Pro? Bem, o Vision Pro usa o ambiente ao seu redor para flutuar na tela inicial, por isso precisa saber o quão perto você está das paredes e dos móveis. Tudo isso é conseguido usando seu scanner LiDAR.

Quatro unidades de medida internas

Unidades de Medição Interna (IMUs) são normalmente usadas em drones. Eles são dispositivos que fornecem sensores internos, como giroscópios e acelerômetros, para fornecer dados de aceleração e orientação para que você possa medir inclinação, rotação e guinada. Eles também podem ser usados para calcular posição e velocidade. O Vision Pro está usando isso para manter sua noção de onde está no mundo, afinal, você não pode esperar que as pessoas fiquem apenas em um lugar ao usar a realidade mista.

Sensor de cintilação

Um sensor de oscilação foi introduzido pela primeira vez pela Apple no iPhone 7. Ele lê a oscilação da luz artificial e pode compensá-la nas fotos e vídeos que você tira. Como o Vision Pro é usado principalmente em ambientes internos com luz artificial, você pode ver por que a Apple precisaria de um aqui para que, ao ver o mundo ao seu redor através do fone de ouvido Vision Pro, não haja oscilação da luz artificial.

Sensor de luz ambiente

O sensor final do Apple Vision Pro é o sensor de luz ambiente. Um sensor de luz ambiente simplesmente ajusta o brilho da tela para corresponder à área circundante, e você os encontra em todos os tipos de produtos Apple, como Apple Watch e dispositivos iOS, mas o uso mais famoso é para iluminar o teclado do MacBook quando escurece. O Vision Pro claramente precisará de um porque precisa saber o quão brilhante deve tornar a tela, dependendo se ela está sendo usada em ambientes diurnos ou escuros.

Microfones?

Finalmente, precisamos pensar nos microfones porque, embora a Apple permaneça calada sobre o que os seis microfones dentro do Vision Pro contêm, eles provavelmente estão sendo usados para mais do que apenas comandos de voz, de uma forma que os torna quase sensores. Provavelmente, eles estão realizando uma varredura acústica da sala para ajudar a facilitar a ilusão de realidade aumentada e para manter os sons no mesmo lugar quando você vira a cabeça.

Atualizaremos esta seção e o restante do artigo com mais informações sobre os sensores Vision Pro assim que descobrirmos mais.